AI wordt nu gebruikt om kinderporno te genereren en tieners te chanteren: Digitale veiligheidsexpert

Criminelen bieden op het dark web stap-voor-stap handleidingen aan voor het maken van deepfakes van kinderen

Digitale veiligheidsexpert waarschuwt voor criminelen die kunstmatige intelligentie gebruiken om kinderporno te maken

Canopy CMO Yaron Litwin bespreekt hoe criminelen deepfake technologie gebruiken om tieners te chanteren en kinderporno te maken.

De snelle vooruitgang van programma's met kunstmatige intelligentie (AI) die realistische afbeeldingen kunnen genereren, heeft geleid tot een explosie van kinderpornografie en chantagepogingen door criminelen die vastbesloten zijn om kinderen en tieners uit te buiten.

Yaron Litwin, de CMO en Digital Safety Expert voor Canopy, een toonaangevende AI-oplossing voor het bestrijden van schadelijke digitale inhoud, vertelde Fox News Digital dat pedofielen op verschillende manieren gebruik maken van de nieuwe tools, vaak met de bedoeling om beelden van seksuele uitbuiting van kinderen te produceren en te verspreiden via het internet.

Een van deze technieken bestaat uit het bewerken van een echte foto van een volledig geklede tiener om er een naaktfoto van te maken. In een praktijkvoorbeeld van Litwin sloot een 15-jarige jongen die geïnteresseerd was in persoonlijke fitness zich aan bij een online netwerk van sportschoolfanaten. Op een dag deelde hij een foto met zijn blote borst na een workout met de groep. Die foto werd genomen, bewerkt tot een naaktfoto en gebruikt om de tiener te chanteren, die aanvankelijk dacht dat zijn foto ongevaarlijk was en veilig in de handen van medegymnasten.

In 2022 rapporteerden de grote sociale mediasites een toename van 9% van verdacht materiaal over seksueel misbruik van kinderen op hun platforms. Van die meldingen kwam 85% van digitale platforms van Meta, zoals Facebook, Instagram en WhatsApp.

Antigone Davis, hoofd veiligheid van Meta, heeft eerder verklaard dat 98% van de gevaarlijke inhoud wordt verwijderd voordat iemand het aan hun team meldt en dat het bedrijf meer materiaal over seksueel misbruik van kinderen (CSAM) meldt dan enige andere dienst.

Litwin zei dat het bewerken van bestaande afbeeldingen met AI ongelooflijk makkelijk en snel is geworden, wat vaak leidt tot vreselijke ervaringen voor gezinnen. Dat gebruiksgemak slaat ook over op het maken van volledig verzonnen beelden van seksuele uitbuiting van kinderen, waarbij geen gebruik wordt gemaakt van authentieke foto's.

"Dit zijn geen echte kinderen," zei Litwin. "Dit zijn kinderen die door AI worden gegenereerd en naarmate deze AI, naarmate het algoritme meer van deze beelden ontvangt, kan het zichzelf verbeteren, op een negatieve manier."

Volgens een recente analyse kunnen door AI gegenereerde beelden van kinderen die betrokken zijn bij seksuele handelingen mogelijk het centrale volgsysteem verstoren dat CSAM van het web blokkeert. In zijn huidige vorm is het systeem alleen ontworpen om bekende beelden van misbruik te detecteren in plaats van gegenereerde beelden. Deze nieuwe variabele zou ertoe kunnen leiden dat wetshandhavers meer tijd moeten besteden aan het bepalen of een afbeelding echt is of door AI is gegenereerd.

Litwin zei dat deze afbeeldingen ook unieke vragen opwerpen over wat er in strijd is met de staats- en federale wetten voor kinderbescherming en pornografie. Hoewel rechtshandhavers en ambtenaren van het Ministerie van Justitie bevestigen dat dergelijk materiaal illegaal is, zelfs als het kind in kwestie door AI gegenereerd is, is er nog geen rechtszaak over geweest.

Bovendien geven juridische argumenten uit het verleden aan dat dergelijke inhoud een grijs gebied zou kunnen zijn in de Amerikaanse wetgeving. Zo verwierp het Hooggerechtshof in 2002 verschillende bepalingen die virtuele kinderpornografie verboden, met het argument dat de uitspraak te breed was en zelfs afbeeldingen van tienerseksualiteit in populaire literatuur zou kunnen omvatten en strafbaar zou kunnen stellen.

Toenmalig opperrechter William H. gaf een onheilspellend commentaar dat veel van de ethische zorgen van de nieuwe AI-revolutie voorspelde .

"Het Congres heeft een dwingend belang om de mogelijkheid te garanderen om verbodsbepalingen van daadwerkelijke kinderpornografie te handhaven, en we moeten ons neerleggen bij de bevindingen van het Congres dat de snel voortschrijdende technologie het binnenkort welhaast onmogelijk zal maken om dit te doen," zei hij.

Verschillende andere factoren hebben de bezorgdheid over online seksuele uitbuiting van kinderen vergroot. Terwijl generatieve AI-tools enorm nuttig zijn geweest bij het maken van nieuwe foto's, kunstwerken en geïllustreerde romans, gebruiken pedofielen nu speciale browsers om deel te nemen aan forums en stap-voor-stap gidsen te delen over hoe ze gemakkelijk nieuw illegaal materiaal kunnen maken. Deze afbeeldingen worden vervolgens gedeeld of gebruikt om een nep online personage te creëren om met kinderen te praten en hun vertrouwen te winnen.

Hoewel de meeste AI-programma's, zoals Stable Diffusion, Midjourney en DALL-E, beperkingen hebben op welke aanwijzingen het systeem zal reageren, zegt Litwin dat criminelen gebruik beginnen te maken van open-source algoritmen die beschikbaar zijn op het dark web. In sommige gevallen kunnen gemakkelijk toegankelijke AI-programma's ook worden misleid, door specifieke bewoordingen en associaties te gebruiken om de bestaande vangrails te omzeilen en te reageren op mogelijk schadelijke prompts.

Volgens Litwin zijn deze afbeeldingen vanwege de grote overvloed aan gegenereerd expliciet materiaal moeilijk te blokkeren en te filteren, waardoor het makkelijker is om kinderen te lokken en ze bloot te stellen aan schadelijke inhoud.

"Als ik niet in deze branche zat, weet ik niet of ik als ouder volledig op de hoogte zou zijn van waar dit naartoe kan gaan en wat er gedaan kan worden," voegde Litwin eraan toe.

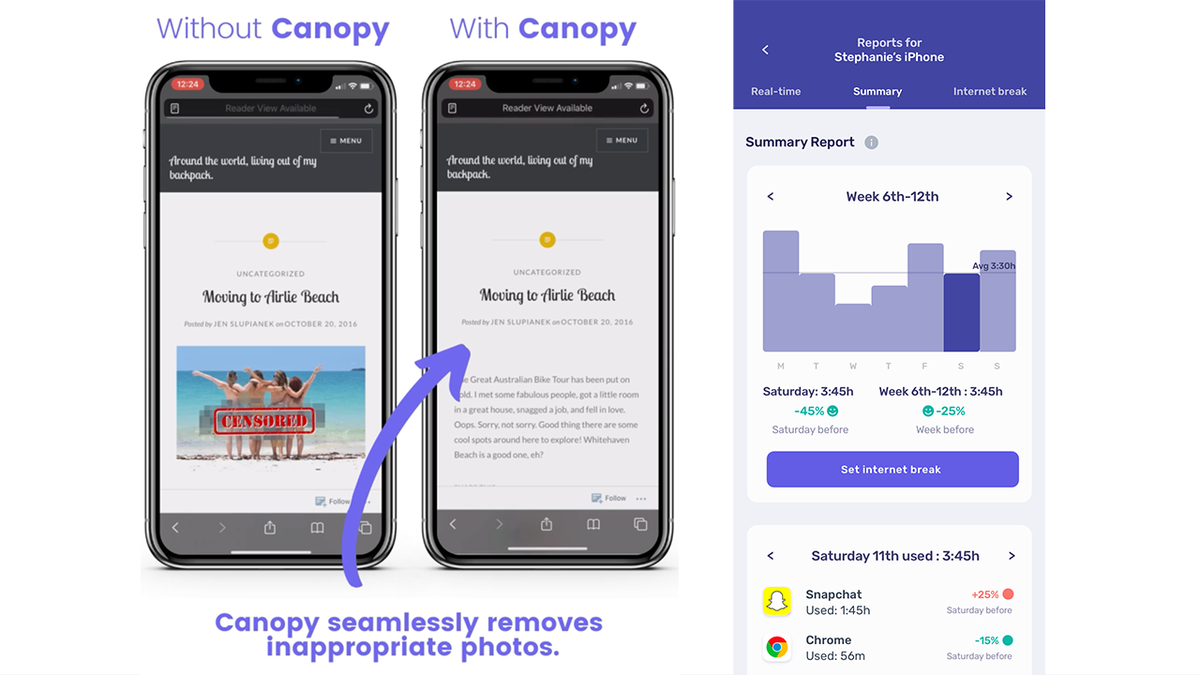

Hij merkte echter op dat, hoewel AI mogelijk schadelijk kan zijn voor kinderen, Canopy ontwikkeld is, door 14 jaar training van AI-algoritmes, om een voorbeeld te zijn van "AI ten goede"

Canopy is een digitale ouderschapsapp die ongepaste inhoud detecteert en blokkeert in milliseconden voordat deze het scherm van de computer of telefoon van een kind bereikt.

"Als je op het internet surft, als je op sociale media kijkt, als er een afbeelding tevoorschijn komt, wordt die eruit gefilterd. De meeste producten blokkeren gewoon de hele website. Zodra het een potentiële afbeelding identificeert. Wij kunnen eigenlijk gewoon alles filteren, zodat u nog steeds kunt browsen," zei Litwin.

De oplossing maakt gebruik van geavanceerde computertechnologie, waaronder AI en machine learning, om ongepaste inhoud op het web en populaire sociale media-apps te herkennen en uit te filteren.

Naast het Smart Filter, dat ongepaste afbeeldingen en video's detecteert en blokkeert, biedt Canopy sextingwaarschuwingen die kunnen helpen detecteren en voorkomen dat ongepaste foto's worden gedeeld.

"Een kind denkt misschien dat er een kind van zijn of haar leeftijd aan de andere kant zit, terwijl dat in werkelijkheid niet zo is. En dus kunnen we een soort barrière opwerpen tussen misschien een slechte beslissing en de ouders laten beslissen of ze dat willen toestaan of niet," zei Litwin.

De oplossing bevat ook Removal Prevention, die ervoor zorgt dat Canopy niet kan worden verwijderd of uitgeschakeld zonder toestemming van een ouder of voogd.

Nikolas Lanum is video-editor voor Fox News Digital.